Ich habe einen Haufen Vorträge gesehen und nachdem ich nun meine Highlights schon beschrieben habe, kommen wir zu der Kategorie „Ferner liefen…“. Hier findet sich sowohl Gutes als auch Schlechtes 😉

Adobe Air, eine neue Basis für Onlinehilfen?

Der erste Vortrag meines Tagungsprogramms lieferte einen gute Überblick über das was Air ist, was es kann und wozu es gut ist. Die Folien gibt es online.

Content Reuse – Zusammenspiel von Software-Entwicklung und Technischer Dokumentation

Definitiv eine der größten Enttäuschungen (neben der Tatsache, dass ich in manche Workshops nicht mehr reinkam). Es ging hier um ein Beispiel in dem für die Dokumentation die strukturierten Daten, die schon bei den Entwicklern vorkamen, wiederverwendet werden konnten. In diesem Fall handelte es sich um 15.000 Fehlermeldungen, deren Kodierung und Text über XML dann an die Doku weitergereicht wurde, auf dass diese die entsprechenden Erklärungen schreibt. Klar, das ist Reuse, aber definitiv eine Variante, die in der freien Wildbahn echt nicht oft auftaucht. Und in der Vortragsbeschreibung kam das auch ganz klar nicht raus. Da haben sehr viele etwas anderes erwartet 🙁

Von 0 auf XML in 80 Tagen: Einführung eines XML Redaktionssystems auf Basis von Funktionsdesign

Hier hat der Kaffeemaschinenhersteller Jura vorgestellt, wie die Doku sich bei ihnen entwickelt hat. Irgendwann wurde ein Cut gemacht bei dem entschlossen wurde, dass nicht mehr Entwickler die Doku schreiben *lach*. Es wurde ein Funktionsdesign entwickelt, das dann auf alle neuen Anleitungen angewandt wurde. Irgendwann war alles an Doku standardisiert und dann kam man auf die Idee ein CMS einzusetzen. Und nachdem man sich für ein CMS entschieden hatte, dauerte es tatsächlich nur 80 Tage bis es einsatzbereit und mit bisherigem Content angefüllt war. Herrlich! Genauso sollte es laufen. Naja, bis auf die Tatsache InDesign einzusetzen… Aber ansonsten bin ich neidisch 🙂

Wissensmanagement bei dezentraler Dokumentationserstellung für multiple Märkte, Marken und Sprachen

Die Essenz dieses Vortrags war, dass jedes Wissen, dass in einem Prozess wichtig ist, auch in diesem Prozess verankert sein muss. Ein durchaus interessanter Ansatz. Sehr schön fand ich den Begriff „Denk-dran-Lösungen“: er wurde hier für alle Informationsinseln verwendet, die sich mit der Zeit in einem Unternehmen entwickeln. Ein bisschen schade fand ich, dass der Redner Wikis komplett als Lösungswegs ausgeschlossen hat, weil sie zu „unstrukturiert“ wären und ja auch bei der Wikipedia nur 1% der Nutzer auch aktiv wären, was bei einer Firma dann auch nichts bringen würde. Aus eigener Erfahrung kann ich sagen, dass die Wikipedia nicht mit einem Wiki in einem Firmenumfeld vergleichbar ist. Letzten Endes lebt jedes Wissensmanagementsystem davon es gut an die Mitarbeiter zu vermarkten, sei es ein schnödes Wiki oder irgendetwas Kommerzielles.

An overview of localization in Latin America

Der Titel sagt genau worum es ging, aber noch treffender wäre der Begriff „localization industry“ gewesen. Ich hatte mir erhofft zu hören, was es für Strategien oder Tipps gibt, wenn man für Lateinamerika lokalisieren muss. Aber es ging wirklich nur um die Lokalisierungsindustrie dort. Das einzig Interessante war hier die Anmerkung, dass man sich als Unternehmen durchaus mal überlegen solle, ob es nicht effizienter und qualititatv besser wäre, die Lokalisierung in die jeweiligen Länder zu geben. Mir kam es alles in allem mehr wie eine Marketingveranstaltung für die Lok-Industrie da drüben vor.

Writing for an International Audience

Gute Zusammenfassung dazu wie schlechte Doku und auch Gedankenlosigkeit die Übersetzungskosten in die Höhe treiben können und am Ende vielleicht doch nur Müll rauskommt, weil eben Müll reinkam. Schönstes Rechenbeispiel: wie die Änderung eines Field Labels am Ende 5500$ kostet 😀

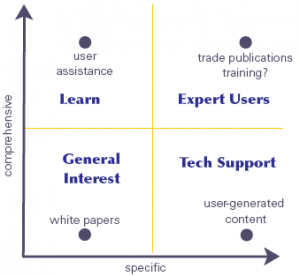

Zielgruppen im Fokus – Zielgruppendefinition in der Technischen Dokumentation

Hm ja, das Übliche eigentlich:

- site visits

- workshops

- Fragebögen

- Communities

- Usability-Tests

- Auswertung der Definitionen von Marketing und Vertrieb

Interessant war der Ansatz, dass man festlegen sollte, welche Zielgruppe strategisch wichtig für das Produkt ist (sowas macht dann wahrscheinlich das produktmanagement) und dann die Redaktion deren Kommunikationsbedürfnisse ermittelt. Einfaches Beispiel: ein Flugzeugtechniker braucht für die tägliche Arbeit kein umfangreiches Handbuch, sondern vielleicht eher eine Loseblatt-Sammlung mit Checklisten.

Das Deutsch der Technischen Redaktion

Bei einer Kaffeepause erzählte mir eine Kommilitonin, dass Prof. Baumert aus Hannover ganz tolle Vorlesungen halten soll. Und so bin ich ganz spontan hineingelaufen – der Vortragsraum war schon 10min vor Beginn randvoll. Ich war hin und weg: er legte los mit den philosophischen Grundlagen, die letzten Endes unser alle Muthig+Schäflein-Armbruster zum Designen des Funktionsdesigns verleiteten. Supertoll vorgetragen und wirklich interessant, weil ich bisher eigentlich immer nur wusste, dass das Funktionsdesign aus der Sprechakttheorie hervorgeht. Aber mehr auch nicht.

Leider musste ich während des Vortrags wg. eines Termins raus. Sehr schade!

Fazit

Ich war teilweise doch sehr enttäuscht darüber, wie sehr manche Vortragsbeschreibungen von der Realität abwichen und man dann in einem Vortrag nach 5min merken musste, dass man wohl in die Falle getappt war.

Leider sind auch einige Vorträge ausgefallen, die ich sehr gern gehört hätte.

Alles in allem fand ich es aber trotzdem sehr gelungen. Ich hatte einige schöne Highlights, habe alte und neue Bekannte getroffen und nächstes Jahr werde ich wohl hoffenltich auch dazu kommen mehr von Wiesbaden zu sehen als die Messe und das Hotel 😉